수리 통계 6. 추정

chapter 1. 데이터 축소 원칙

확률표본 \(X_{1},\ldots,X_{n}\)으로부터 미지의 모수 \(\theta\)에 대해 추론을 시도한다. 표본크기 \(n\)이 크면 관찰된 표본 데이터 \(x_{1},\ldots,x_{n}\)은 해석하기 어려운 긴 수열이 될 수 있으므로, 데이터 내 정보를 요약하기 위해 확률표본의 함수인 통계량을 계산한다. 데이터 축소 또는 요약의 한 형태인 \(T(\mathbf{X})\)는 동일한 값을 갖더라도 상이한 표본일 수 있다.

여기서는 데이터 축소의 세 가지 원리에 대해 살펴본다. 미지의 모수 \(\theta\)에 대한 중요한 정보를 버리지 않고 데이터 요약을 수행하는 방법과, 반대로 \(\theta\)에 대한 지식 획득에 무관한 정보를 성공적으로 제거하는 방법이다.

충분성 원리 sufficiency principle: 데이터를 요약하는 과정에서도 \(\theta\)에 관한 정보를 버리지 않는 방법을 제시

우도 원리 likelihood principle: 관찰된 확률표본을 통해 얻어진 \(\theta\)에 대한 모든 정보를 담고 있는 파라미터의 함수를 기술

등분산성 원리 equivariance principle: 모형의 중요한 특성들을 유지하면서 또 다른 형태의 데이터 축소를 가능하게 하는 방법을 제시

1. 충분성 원리

충분통계량은 어떤 모수 \(\theta\)에 대해, 확률표본에 포함된 \(\theta\)에 관한 모든 정보를 포착하는 통계량을 의미한다. 확률표본의 충분통계량 값 이외에 추가로 얻을 수 있는 표본의 다른 정보는 \(\theta\)에 대해 더 이상 아무런 정보를 제공하지 않는다.

【정의】 \(T(\mathbf{X})\)가 모수 \(\theta\)에 대한 충분통계량이라면 \(\theta\)에 대한 모든 추론은 확률표본 \(\mathbf{X}\)의 전체 값이 아니라 \(T(\mathbf{X})\)의 값만을 통해 이루어져야 한다. 즉, 두 표본 점 \(\mathbf{x}\)와 \(\mathbf{y}\)가 \(T(\mathbf{x}) = T(\mathbf{y})\)를 만족하면, \(\theta\)에 대한 추론은 \(\mathbf{X} = \mathbf{x}\)가 관측되었을 때와 \(\mathbf{X} = \mathbf{y}\)가 관측되었을 때 동일해야 한다.

(1) 충분통계량

【정의】 통계량 \(T(\mathbf{X})\)가 모수 \(\theta\)에 대한 충분통계량이 되기 위한 조건은 다음과 같다: 조건부 분포 \(f_{\mathbf{X}|T(\mathbf{X})}(\mathbf{x}|T(\mathbf{X}) = t)\)가 모수 \(\theta\)에 의존하지 않을 때, \(T(\mathbf{X})\)는 \(\theta\)에 대한 충분통계량이다.

즉, 확률표본 \(\mathbf{X}\)에 대한 조건부 분포가 통계량 \(T(\mathbf{X})\)의 값만 주어진 상태에서 \(\theta\)와 무관하다면, \(T(\mathbf{X})\)만 가지고도 \(\theta\)에 대해 모든 정보를 담고 있다고 본다.

【정리】 \(p(\mathbf{x}|\theta)\)를 확률표본 \(\mathbf{X}\)의 결합확률밀도함수라 하고, 통계량 \(T(\mathbf{X})\)의 확률밀도함수를 \(q(t|\theta)\)라 하자. 통계량 \(T(\mathbf{X})\)가 모수 \(\theta\)에 대한 충분통계량이 되기 위한 필요충분조건은, 모든 표본 \(\mathbf{x}\)에 대하여 비율 \(\frac{p(\mathbf{x}|\theta)}{q(T(\mathbf{X})|\theta)} = H(x_1,x_2,...,x_n)\) 이 모수 \(\theta\)에 의존하지 않는 상수일 때이다.

【예제 ①】 \(X_{1},\ldots,X_{n}\)을 모수 \(\theta \in (0,1)\)인 베르누이 분포를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = \sum X_{i}\)는 \(\theta\)에 대한 충분통계량이다.

\(T(\mathbf{X}) = \sum X_{i} \sim B(n,\theta)\)이므로 \(q(T(\mathbf{x})|\theta) \sim \binom{n}{t}\theta^{t}(1 - \theta)^{n - t}\)

결합확률밀도함수는 \(p(\mathbf{x}|\theta) = \prod\theta^{x_{i}}(1 - \theta)^{1 - x_{i}}\)이다.

\[\frac{p(\mathbf{x}|\theta)}{q(T(\mathbf{x})|\theta)} = = \frac{\theta^{t}(1 - \theta)^{n - t}}{\binom{n}{t}\theta^{t}(1 - \theta)^{n - t}} = \frac{1}{\binom{n}{t}} = \frac{1}{\binom{n}{\sum x_{i}}}\]

【예제 ②】 \(X_{1},\ldots,X_{n}\)을 \(\sigma^{2}\)가 알려진 \(N(\mu,\sigma^{2})\) 정규분포를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = \sum X_{i}/n\)는 \(\mu\)에 대한 충분통계량이다.

\[f(\mathbf{x}|\mu) = \overset{n}{\prod_{i = 1}}(2\pi\sigma^{2})^{- 1/2}\exp\left( - \frac{(x_{i} - \mu)^{2}}{2\sigma^{2}} \right)\]

\[\overline{X} \sim N(\mu,\sigma^{2}/n)\]

\[\frac{f(\mathbf{x}|\theta)}{q(T(\mathbf{x})|\theta)} = (2\pi\sigma^{2})^{- n/2}\exp\left( - \frac{\sum_{i = 1}^{n}(x_{i} - \overline{x})^{2} + n(\overline{x} - \mu)^{2}}{2\sigma^{2}} \right)/(2\pi\sigma^{2}/n)^{- 1/2}\exp\left( - \frac{n(\overline{x} - \mu)^{2}}{2\sigma^{2}} \right)\]

\[= n^{- 1/2}(2\pi\sigma^{2})^{- (n - 1)/2}\exp\left( - \frac{\sum_{i = 1}^{n}(x_{i} - \overline{x})^{2}}{2\sigma^{2}} \right)\]

【예제 ③】 지수족 분포를 벗어나면 순서통계량보다 작은 차원의 충분통계량을 찾는 것은 불가능 하다. 비모수 검정이 필요하다.

\(X_{1},\ldots,X_{n}\)이 임의의 확률밀도함수 \(f(x)\)로부터 확률분포로 추출되었다고 하자. 이때 \(f(x)\)에 대한 추가적인 정보가 없는 경우(비모수 추정 상황)에는 확률표본의 순서통계량만이 정보를 담는다. 즉,

\(f(\mathbf{x}) = \overset{n}{\prod_{i = 1}}f(x_{i}) = \overset{n}{\prod_{i = 1}}f(x_{(i)})\)가 성립하므로 위의 정리에 따라 순서통계량이 충분통계량이 된다.

(분해 정리, Factorization Theorem) \(f(\mathbf{x}|\theta)\)를 표본 \(\mathbf{X}\)의 결합확률밀도함수라 하자. 통계량 \(T(\mathbf{X})\)가 \(\theta\)에 대한 충분통계량이 되기 위한 필요충분조건은 다음과 같다. 모든 \(\mathbf{x}\)와 \(\theta\)에 대해, 함수 \(g(t|\theta)\)와 \(h(\mathbf{x})\)가 존재하여 \(f(\mathbf{x}|\theta) = g(T(\mathbf{x})|\theta)h(\mathbf{x})\)를 만족할 때, \(T(\mathbf{X})\)는 \(\theta\)에 대한 충분통계량이다.

표본의 확률함수를 충분통계량만을 통한 함수 \(g\)와 \(\mathbf{x}\)에만 의존하는 함수 \(h\)로 분해할 수 있으면, 그 통계량은 충분하다. 분해정리를 이용하여 충분통계량을 찾기 위해서는 확률표본의 결합확률밀도함수를 두 부분으로 분해한다. 한 부분은 모수 \(\theta\)에 의존하지 않는 부분이고 다른 부분은 \(\theta\)에 의존하는 부분이다.

【예제 ② 계속】 \(X_{1},\ldots,X_{n}\)을 \(\sigma^{2}\)가 알려진 \(N(\mu,\sigma^{2})\) 정규분포를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = \sum X_{i}/n\)는 \(\mu\)에 대한 충분통계량이다.

\[f(\mathbf{x}|\mu) = (2\pi\sigma^{2})^{- n/2}\exp\left( - \overset{n}{\sum_{i = 1}}(x_{i} - \overline{x})^{2}/(2\sigma^{2}) \right)\exp\left( - n(\overline{x} - \mu)^{2}/(2\sigma^{2}) \right)\]

\[h(\mathbf{x}) = (2\pi\sigma^{2})^{- n/2}\exp\left( - \frac{1}{2\sigma^{2}}\overset{n}{\sum_{i = 1}}(x_{i} - \overline{x})^{2} \right)\]

\(g(t|\mu) = \exp\left( - \frac{n(t - \mu)^{2}}{2\sigma^{2}} \right)\)이므로 \(f(\mathbf{x}|\mu) = g(t|\mu)h(\mathbf{x})\)

【예제 ④】 \(X_{1},\ldots,X_{n}\)을 \(f(x|\theta) = \frac{1}{\theta},x = 1,2,...,\theta\) 이산형 균일분포를 따르는 확률표본이라 하자. \(max(x_{i})\)는 \(\theta\)에 대한 충분통계량이다.

\[f(\mathbf{x}|\theta) = \{\begin{matrix} \theta^{- n}, & \text{if}x_{i} \in \{ 1,2,\ldots,\theta\}\text{for all}i = 1,\ldots,n \\ 0, & \text{otherwise} \end{matrix}\]

\[h(\mathbf{x}) = \{\begin{matrix} 1, & \text{if}x_{i} \in \{ 1,2,\ldots\}\text{for all}i = 1,\ldots,n \\ 0, & \text{otherwise} \end{matrix}\]

\(T(\mathbf{x}) = \max_{i}x_{i}\)이면, \(g(t|\theta) = \{\begin{matrix} \theta^{- n}, & \text{if}t \leq \theta \\ 0, & \text{otherwise} \end{matrix}\)

【예제 ⑤】 \(X_{1},\ldots,X_{n}\)을 \(N(\mu,\sigma^{2})\) 정규분포를 따르는 확률표본이라 하자. \(T_{1}(\mathbf{x}) = \overline{X}\), \(T_{2}(\mathbf{x}) = S^{2} = \frac{1}{n - 1}\overset{n}{\sum_{i = 1}}(X_{i} - \overline{X})^{2}\)은 모수 \((\mu,\sigma^{2})\)에 대한 충분통계량이다.

\(T_{1}(\mathbf{x}) = \overline{X}\), \(T_{2}(\mathbf{x}) = S^{2}\)에 대하여 \(h(x) = 1\)이고

\[g(t_{1},t_{2} \mid \mu,\sigma^{2}) = (2\pi\sigma^{2})^{- n/2}\exp\left( - \frac{n(t_{1} - \mu)^{2} + (n - 1)t_{2}}{2\sigma^{2}} \right)\]

\[f(\mathbf{x} \mid \mu,\sigma^{2}) = g\left( T_{1}(\mathbf{x}),T_{2}(\mathbf{x}) \mid \mu,\sigma^{2} \right)h(\mathbf{x})\]

【정리】 \(f(x \mid \theta) = h(x)c(\mathbf{\theta})\exp\left( \overset{k}{\sum_{i = 1}}w_{i}(\mathbf{\theta})t_{i}(x) \right)\) 지수족 분포로부터의 충분통계량은 \(T(\mathbf{X}) = \left( \overset{n}{\sum_{j = 1}}t_{1}(X_{j}),\overset{n}{\sum_{j = 1}}t_{2}(X_{j}),\ldots,\overset{n}{\sum_{j = 1}}t_{k}(X_{j}) \right)\)이다.

(2) 최소 충분통계량

충분통계량은 모수 \(\theta\)에 대한 정보를 표본에서 손실 없이 요약할 수 있는 통계량이다. 그런데 모든 충분통계량이 ”작거나 간단한” 것은 아닙니다. 어떤 충분통계량은 더 많은 정보를 담고 있을 수도 있다. 최소 minimal 충분통계량은 다음을 만족한다.

정보를 모두 보존하면서 가장 작고 요약된 형태로 되어 있는 충분통계량이다.

즉, 중복 없이 핵심 정보만 유지하는 가장 효율적인 통계량이다.

【정의】 어떤 충분통계량 \(T(\mathbf{X})\)이 모든 다른 충분통계량 \(T'(\mathbf{X})\)에 대해, \(T(\mathbf{X})\)이 \(T'(\mathbf{X})\)의 함수로 표현될 수 있으면 \(T(\mathbf{X})\)을 최소 충분통계량이라고 한다.

【정리】 확률표본 \(\mathbf{X}\)의 확률밀도함수가 \(f(\mathbf{x}|\theta)\)로 주어졌다고 하자.

어떤 함수 \(T(\mathbf{x})\)가 존재하여, 모든 표본점 \(\mathbf{x},\mathbf{y}\)에 대해 \(\frac{f(\mathbf{x}|\theta)}{f(\mathbf{y}|\theta)}\)가 \(\theta\)에 대해 상수가 되는 경우가 \(T(\mathbf{x}) = T(\mathbf{y})\)일 때와 정확히 일치한다면, \(T(\mathbf{X})\)는 \(\theta\)에 대한 최소 충분통계량이다.

【예제 ⑥】 확률표본 \(X_{1},\ldots,X_{n}\)이 \(\text{N}(\mu,\sigma^{2})\)에서 추출되었고 모수 \((\mu,\sigma^{2})\) 둘 다 모를 경우 \((\overline{x},s^{2})\)는 최소 충분통계량이다.

\[\frac{f(\mathbf{x}|\mu,\sigma^{2})}{f(\mathbf{y}|\mu,\sigma^{2})} = \exp\left( \left\lbrack - n({\overline{x}}^{2} - {\overline{y}}^{2}) + 2n\mu(\overline{x} - \overline{y}) - (n - 1)(s_{x}^{2} - s_{y}^{2}) \right\rbrack/(2\sigma^{2}) \right)\]

이 비가 \((\mu,\sigma^{2})\)에 대해 상수가 되려면 \(\overline{x} = \overline{y},s_{x}^{2} = s_{y}^{2}\)

이어야 한다. 따라서, 표본평균 \(\overline{X}\)와 표본분산 \(S^{2}\)는 \((\mu,\sigma^{2})\)

에 대한 최소 충분통계량이다.

【예제 ⑦】 확률표본 \(X_{1},\ldots,X_{n}\)이 \(U(\theta,\theta + 1)\)에서 추출되었다고 하자. \(T(\mathbf{X}) = (X_{(1)},X_{(n)})\)은 모수 \(\theta\)에 대한 최소 충분통계량이다.

\[f(\mathbf{x}|\theta) = \{\begin{matrix} 1 & \text{if}\theta < x_{i} < \theta + 1,\text{for all}i = 1,\ldots,n \\ 0 & \text{otherwise} \end{matrix}\]

\[f(\mathbf{x}|\theta) = \{\begin{matrix} 1 & \text{if}\max_{i}x_{i} - 1 < \theta < \min_{i}x_{i} \\ 0 & \text{otherwise} \end{matrix}\]

두 표본 \(\mathbf{x},\mathbf{y}\)에 대하여, 비율 \(\frac{f(\mathbf{x}|\theta)}{f(\mathbf{y}|\theta)}\)이 \(\theta\)에 대해 항상 일정하려면 \(\min_{i}x_{i} = \min_{i}y_{i},\max_{i}x_{i} = \max_{i}y_{i}\)이어야 한다.

최소 충분통계량은 유일하지 않다.

\(T'(\mathbf{X}) = (X_{(n)} - X_{(1)},(X_{(n)} + X_{(1)})/2)\),

\(T'(\mathbf{X}) = \left( \overset{n}{\sum_{i = 1}}X_{i},\overset{n}{\sum_{i = 1}}X_{i}^{2} \right)\) 또한 최소 충분통계량이다.

(3) 보조 통계량

【정의】 통계량 \(S(\mathbf{X})\)의 분포가 모수 \(\theta\)와 무관할 때, 이를 보조 ancillary 통계량이라고 한다.

【예제 ⑦ 계속】 확률표본 \(X_{1},\ldots,X_{n}\)이 \(U(\theta,\theta + 1)\)에서 추출되었다고 하자. \(T(\mathbf{X}) = (X_{(1)},X_{(n)})\)은 모수 \(\theta\)에 대한 최소 충분통계량이므로 \(R = X_{(n)} - X_{(1)}\)은 보조 통계량이다.

\[g(x_{(1)},x_{(n)} \mid \theta) = \{\begin{matrix} n(n - 1)(x_{(n)} - x_{(1)})^{n - 2} & \text{if}\theta < x_{(1)} < x_{(n)} < \theta + 1 \\ 0 & \text{otherwise}. \end{matrix}\]

\(R = X_{(n)} - X_{(1)},M = \frac{X_{(1)} + X_{(n)}}{2}\) 변수변환 하면,

\[h(r,m \mid \theta) = \{\begin{matrix} n(n - 1)r^{n - 2}, & \text{if}0 < r < 1,\theta + \frac{r}{2} < m < \theta + 1 - \frac{r}{2} \\ 0, & \text{otherwise}. \end{matrix}\]

\[h(r \mid \theta) = n(n - 1)r^{n - 2}(1 - r),0 < r < 1 \sim Beta(n - 1,2)\]

\(R = X_{(n)} - X_{(1)}\)의 확률밀도함수는 모수 \(\theta\)에 의존하지 않는다.

(4) 완비 통계량

최소 충분통계량은 표본으로부터 모수 \(\theta\)에 대한 모든 정보를 유지하면서, 그 외의 불필요한 정보를 최대한 제거한 통계량이다. 즉, 표본에서 모수와 관련된 핵심 정보만을 남기는 데이터 축약 방법이다. 반면, 보조 통계량은 그 분포가 모수 \(\theta\)에 의존하지 않는 통계량으로 모수에 대한 정보를 전혀 담고 있지 않다.

이 둘은 개념적으로 구별되지만, 반드시 독립적이지는 않다. 예를 들어, \(uniform(\theta,\theta + 1)\)에서, 최소값과 최대값의 조합인 \((X_{(n)} - X_{(1)},(X_{(n)} + X_{(1)})/2)\)은 최소 충분통계량이 되고, 그 중 \(X_{(n)} - X_{(1)}\)은 보조 통계량이 된다. 이 경우, 최소 충분통계량과 보조 통계량은 서로 독립하지 않으며, 오히려 하나의 구성요소가 된다.

보조 통계량은 모수 추정 정밀도에 기여

\(X_{1},X_{2}\)가 다음 이산분포 에서 독립적으로 관측되었다.\(P_{\theta}(X = \theta) = P_{\theta}(X = \theta + 1) = P_{\theta}(X = \theta + 2) = \frac{1}{3}\). 순서 통계량 \(X_{(1)},X_{(2)}\)으로 \(R = X_{(2)} - X_{(1)},M = (X_{(1)} + X_{(2)})/2\)를 정의하면, \((R,M)\)은 최소 충분통계량이고, \(R\)은 보조 통계량이다.

그러나 \(R\)이 보조 통계량임에도 불구하고 모수 \(\theta\)에 대해 간접적으로 중요한 정보를 제공할 수 있다. 예를 들어, 단순히 \(M = m\)이라는 정보만 알고 있을 때, 가능한 \(\theta\) 값은 \(m,m - 1,m - 2\) 세 가지가 된다. 하지만 추가로 \(R = 2\)라는 정보를 알게 되면, \(X_{(1)} = m - 1,X_{(2)} = m + 1\)이 되어, 가능한 \(\theta\) 값이 유일하게 \(m - 1\)로 결정된다. 즉, 보조 통계량 \(R\)이 모수 추정의 정밀도를 높이는 데 기여한 것이다.

【정의】 어떤 통계량 \(T(\mathbf{X})\)에 대해 확률분포족 \(f(t|\theta)\)가 있을 때, 이 분포족을 완비라고 부른다. 완비란, 모든 \(\theta\)에 대해 \(\mathbb{E}\theta\lbrack g(T)\rbrack = 0\)이면서도, \(P_{\theta}(g(T) = 0) = 1\)이 되는 경우를 말한다. 즉, 기대값이 0인 함수 \(g(T)\)는 거의 확률 1로 항상 0이어야 한다는 뜻이다. 이 경우, \(T(\mathbf{X})\)를 완비 통계량 complete 이라고 한다.

【예제 ①】 \(X_{1},\ldots,X_{n}\)을 모수 \(\theta \in (0,1)\)인 베르누이 분포를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = \sum X_{i} \sim B(n,\theta)\)는 \(\theta\)에 대한 완비 충분 통계량이다.

【예제 ②】 확률표본 \(X_{1},\ldots,X_{n}\)이 \(U(0,\theta)\)에서 추출되었다고 하자. \(T(\mathbf{X}) = max(x_{i}) = x_{(n)}\)은 모수 \(\theta\)에 대한 완비 충분 통계량이다.

(Basu’s Theorem) 만약 \(T(\mathbf{X})\)가 완비하고 최소 충분 통계량이라면, \(T(\mathbf{X})\)는 모든 보조 통계량과 서로 독립이다.

완비성과 최소충분성이라는 강력한 조건을 만족할 경우, 매개변수 \(\theta\)와 무관하게 분포하는 보조통계량들과 \(T(\mathbf{X})\)사이에는 어떠한 의존성도 존재하지 않음을 의미한다. 최소충분 통계량과 모수와 무관한 정보보조통계량를 분리할 수 있게 해주기 때문에, 통계 추론이나 신뢰구간 설정에 매우 유용하게 사용된다.

【정리】 \(X_{1},\ldots,X_{n}\)이 지수족 분포를 따르는 확률표본이라고 하자.

\(f(x|\theta) = h(x)c(\theta)\exp\left( \overset{k}{\sum_{j = 1}}w(\theta_{j})t_{j}(x) \right)\). 다음 \(T(\mathbf{X})\)는 완비통계량이다. \(T(\mathbf{X}) = \left( \overset{n}{\sum_{i = 1}}t_{1}(X_{i}),\overset{n}{\sum_{i = 1}}t_{2}(X_{i}),\ldots,\overset{n}{\sum_{i = 1}}t_{k}(X_{i}) \right)\)

(Minimal Complete Statistic) 만약 최소 충분통계량이 존재한다면, 모든 완비통계량도 최소 충분통계량이다.

【예제 ③】 \(X_{1},\ldots,X_{n}\)을 \(exp(\theta)\), 지수분포(지수족)를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = \sum X_{i} \sim Gamma(n,\theta)\)는 \(\theta\)에 대한 완비 최소 충분 통계량이다.

【예제 ④】 \(X_{1},\ldots,X_{n}\)을 \(N(\mu,\sigma^{2})\), 정규분포(지수족)를 따르는 확률표본이라 하자. \(T(\mathbf{X}) = (\overline{X},S^{2})\)는 \(\theta\)에 대한 완비 최소 충분 통계량이다.

2. 우도함수

통계적 추론에서는 데이터로부터 정보를 요약하는 방법이 중요하다. 우도함수는 단순히 하나의 요약 방법이 아니라, 특정 원칙을 수용할 경우 필수적인 데이터 축약 장치로 간주된다.

충분성 원칙: 관찰된 데이터가 어떤 충분한 통계량에 의해서만 정보를 제공한다면, 모든 추론은 이 충분한 통계량에만 의존해야 한다.

조건화 원칙: 실험 설계상 복수의 실험이 가능한 경우, 실제로 수행된 실험의 결과만을 기반으로 추론해야 한다.

우도 원칙: 주어진 데이터에 대한 우도함수의 형태만이 추론에 중요하며, 데이터가 관찰된 경로는 중요하지 않다.

위의 원칙들을 받아들인다면, 우도함수는 주어진 데이터로부터 정보를 요약하는 유일하고 필수적인 수단이 된다.

(1) 우도함수

【정의】 확률표본 \(\mathbf{X} = (X_{1},\ldots,X_{n})\)의 결합 확률밀도함수를 \(f(\mathbf{x}|\theta)\)라고 하자. 이때 표본 데이터 \(\mathbf{X} = \mathbf{x}\)가 관측되었을 때, 모수 \(\theta\)의 함수로 정의되는 \(L(\theta|\mathbf{x}) = f(\mathbf{x}|\theta)\)를 우도함수 likelihood function 라고 한다.

우도함수는 관측된 데이터 \(\mathbf{x}\)를 기준으로 다양한 \(\theta\) 값들에 대해 상대적 타당성을 비교하는 도구이다. 이산형, 연속형 모두 우도비를 통해 두 모수에 대한 비교가 가능하다. 즉, 실제 데이터가 관측되어 우도 값이 계산된다면 우도 값이 큰 모수가 진짜 모수일 가능성이 높다.

【예제 ①】 \(NB(r = 3,p)\), 음이항분포로부터 \(X_{1} = 2\) 관측되었다면 우도함수는 \(P_{p}(X = 2) = \binom{4}{2}p^{3}(1 - p)^{2}\)이다.

【우도 원리】 표본점 \(\mathbf{x},\mathbf{y}\)가 다음 조건을 만족한다고 하자.

두 표본에 대해 우도함수 \(L(\theta|\mathbf{x})\), \(L(\theta|\mathbf{y})\)가 서로 비례한다.

즉, 모든 \(\theta\)에 대해 다음을 만족하는 상수 \(C(\mathbf{x},\mathbf{y})\)가 존재한다.

\[L(\theta|\mathbf{x}) = C(\mathbf{x},\mathbf{y})L(\theta|\mathbf{y}),\text{for all}\theta\]

두 표본 \(\mathbf{x},\mathbf{y}\)가 관찰되었을 때, 만약 이들의 우도함수가 비례한다면, 이 두 표본은 동일한 정보를 제공한다. 통계적 결론은 오직 우도함수 에만 의존해야 하며, 표본의 다른 세부사항에는 의존하지 않는다.

(2) 공식 formal 충분 통계량 원칙

어떤 실험 \(E = (X,\theta,\{ f(x|\theta)\})\)이 수행되었고, \(T(X)\)이 \(\theta\)에 대한 충분통계량이라 할 때, 만약 두 관측값 \(x\)와 \(y\)가 \(T(x) = T(y)\)를 만족한다면, 이 두 관측값이 제공하는 증거는 동일해야 한다는 것이다. 즉, 관측 데이터 전체 \(x\) 자체가 아니라, 그로부터 계산된 충분통계량 \(T(x)\)만이 \(\theta\)에 관한 모든 정보를 요약하므로, 두 데이터가 동일한 충분통계량 값을 가질 때는, 둘 모두 \(\theta\)에 대해 동일한 결론을 가져야 한다.

(3) 조건화 conditionality 원칙

여러 개의 가능한 실험이 있을 때, 어떤 실험이 실제로 수행되었는지가 매우 중요하다는 사실을 강조한다. 예를 들어, 두 개의 실험 \(E_{1},E_{2}\) 중 무작위로 하나를 선택하여 시행한다고 가정하자. 이때, 어느 실험이 선택되었는지는 관측값과 함께 반드시 고려되어야 하며, 실제로 수행된 실험에 기반하여 추론이 이루어져야 한다.

보다 공식적으로, 혼합 실험 \(E\)이 정의될 때, 실험 \(E_{j}(j = 1,2)\)가 수행되고 관측값 \(x_{j}\)가 주어진 경우, \(\text{Ev}(E^{,}(j,x_{j})) = \text{Ev}(E_{j},x_{j})\)이어야 한다. 즉, 실험 \(E\)로부터 얻어진 데이터라도 실제로 수행된 \(E_{j}\)에 기반하여 해석되어야 한다. 조건화 원칙은 ”오직 수행된 실험만이 중요하며, 선택되지 않은 실험들은 전혀 고려되어서는 안 된다”는 점을 명확히 한다. 이는 실험 설계 단계에서 무작위성이 개입되더라도, 실제로 수행된 실험만이 추론의 근거가 되어야 한다는 점에서 자연스럽고 설득력 있는 원칙이다.

(4) 우도 원칙

공식 충분성 원칙과 조건화 원칙을 함께 받아들이면, 우도 원칙이 도출된다. 즉, 두 실험에서 수집된 두 데이터 \(x_{1}^{*},x_{2}^{*}\)가 생성하는 우도함수가 다음과 같은 비례 관계를 만족할 때, \(L(\theta|x_{2}^{*}) = CL(\theta|x_{1}^{*})\)이 두 데이터는 \(\theta\)에 대해 동일한 증거를 제공해야 한다.

따라서 관측 데이터가 생성하는 우도함수만이 파라미터에 관한 모든 정보를 담고 있으며, 우도함수가 같으면 추론 결과도 같아야 한다는 결론에 도달한다. 이는 바로 우도 원칙의 본질이다.

(5) 동등성 Equivariance 원칙

동등성 원칙에서는 함수 \(T(x)\)가 지정되지만, \(T(x) = T(y)\)일 때 \(x\)를 관찰했을 경우와 \(y\)를 관찰했을 경우 추론 결과가 ”일정한 관계”를 가져야 한다고 요구한다. 반드시 동일할 필요는 없지만, 정해진 관계를 따라야 한다는 점이 특징이다. 또한 동등성 원칙은 실제로 두 가지 다른 고려사항을 결합한 것으로 이해할 수 있다:

Measurement Equivariance

측정 단위에 의존하지 않는 추론을 요구한다. 예를 들어, 두 산림 조사원이 각각 나무의 평균 직경을 측정한다고 하자. 한 명은 인치 단위로, 다른 한 명은 미터 단위로 데이터를 수집하였다. 비록 단위가 다르더라도, 최종적으로 동일한 추정값을 제시해야 한다. 즉, 단위 변환(예: 인치를 미터로 변환) 이후 결과가 일치해야 한다.

Formal Invariance

수학적 모델의 구조가 동일하다면 추론 절차 역시 동일해야 한다고 요구한다. 이는 물리적 의미(예: 단위 등)와는 무관하게, 다음 세 가지가 같다면, 동일한 추론 방법을 사용해야 한다는 것이다.

모수 공간 \(\Theta\)

확률밀도함수 \(f(x|\theta)\)

허용 가능한 추론 및 오차

만약 \(Y = g(X)\)가 \(X\)의 측정 단위 변환이고, \(Y\)의 모델이 \(X\)의 모델과 동일한 수학적 구조를 갖는다면, 추론 절차는 측정 단위 변화에 대해 불변하며 동시에 수학적 구조에 대해 불변해야 한다.

【예제 ①】 \(X \sim \text{Binomial}(n,p)\)일 때, 성공 횟수 \(x\)를 관찰한 경우를 생각한다. 실패 횟수는 \(Y = n - X\)로 표현할 수 있으며, 역시 \(\text{Binomial}(n,q = 1 - p)\)분포를 따른다.

Measurement Equivariance 요구

성공 수 \(x\)를 기반으로 한 추정값 \(T(x)\)와 실패 수 \(y = n - x\)를 기반으로 한 추정값 \(T(y)\)는 다음을 만족해야 한다.

\[T(x) = 1 - T(n - x)\text{or}T(x) = 1 - T(n - x)\]

chapter 2. 점 추정

1. 개념

첫 번째 부분은 추정량을 찾는 방법을, 두 번째 부분은 추정량(및 기타 다른 추정량)을 평가하는 방법을 다룬다. 점추정의 논리는 매우 단순하다. 모집단이 확률밀도함수 \(f(x|\theta)\)로 기술될 때 \(\theta\)에 대한 지식은 모집단 전체에 대한 정보를 제공한다. 따라서, \(\theta\)의 좋은 추정량을 찾는 방법을 모색하는 것은 자연스러운 일이다. 또한, 경우에 따라서는 \(\theta\)의 함수, 즉 \(\tau(\theta)\)가 관심 대상이 될 수도 있다.

【정의】 점추정량은 확률표본의 함수 \(W(X_{1},\ldots,X_{n})\)이다. 즉, 모든 통계량은 점추정량이다.

모집단 확률분포함수 \(f(x;\theta),\theta \in \Omega\)의 확률표본에서 얻은 통계량이 추정에 사용된다면 이를 추정량 estimator 이라 한다. 근사할 것이라고 생각하는 하나의 값으로 제시한다면 이를 점추정 point estimate, \(\theta\)을 포함하고 있을 가능성이 높은 구간을 제시하는 것은 구간추정 interval estimate이라 한다. 계산되는 공식을 추정량, 실제 데이터를 이용하여 계산된 값을 추정치 estimates 이라 한다.

【정의】 모집단 확률분포함수 \(f(x;\theta),\theta \in \Omega\)의 확률표본에서 얻은 통계량 \(T = T\left( X_{1},X_{2},\ldots,X_{n} \right)\)이 모수 추정에 사용되면 이를 추정량 이라 하고 \(\overset{\hat{}}{\theta}\)이라 표현한다.

추정량 : \(\overset{\hat{}}{\theta} = T(X_{1},X_{2},\ldots,X_{n})\) 대문자로 표현

추정치 : : \(t(x_{1},x,\ldots,x_{n})\) 관측된 값으로 소문자로 표현

2. 추정량 구하는 방법

(1) 적률법

가장 오랜 방법으로 적률을 이용하여 모수 추정하는 방법으로 매우 간단하나 좋은 추정량의 조건을 갖추지 않을 수 있다.

알려지지 않은 모집단 확률분포함수 \(f(x;\theta),\theta \in \Omega\), 확률표본 \(\left( X_{1},X_{2},\ldots,X_{n} \right)\)에서 모집단의 \(k\)차 적률 \({\mu'}_{k} = E(X^{k})\)과 표본의 \(k\)차 적률 \(m_{k}' = E(X_{i}^{k})\)이라 하자.

\(\mu_{k}' = m_{k}\)이라 놓고 풀면 모수 추정량 얻게 된다. 만약 모수 한 개 이상이면 적률에 의한 방정식을 모수 수만큼 얻어 사용하면 된다.

【예제 ①】 모집단 \(B(n,p)\)으로부터 확률표본 \(\left( X_{1},X_{2},\ldots,X_{n} \right)\)이다. 적률방법으로 추정량 \(\overset{\hat{}}{n},\overset{\hat{}}{p}\) 구하라.

모집단 적률: \(\mu_{1}' = E(X) = np,\mu_{2}' = E\left( X^{2} \right) = np(1 - p) + {(np)}^{2}\)

표본적률: \(m_{1}' = E(X) = \overset{¯}{X}\), \(m_{2}' = E\left( X^{2} \right) = \frac{1}{n}\sum X_{i}^{2}\)

방정식: \(np = \overset{¯}{X}\), \(\frac{1}{n}\sum X_{i}^{2}\)=\(= np(1 - p) + {(np)}^{2}\)

모비율 추정량 : \(\widehat{p} = \overline{x}\)

【예제 ②】 모집단 \(N(\mu,\sigma^{2})\)으로부터 확률표본 \(\left( X_{1},X_{2},\ldots,X_{n} \right)\)이다. 적률방법으로 \(추정량\overset{\hat{}}{\mu},\overset{\hat{}}{\sigma^{2}}\) 구하라.

모집단 적률: \(\mu_{1}' = E(X) = \mu,\mu_{2}' = E\left( X^{2} \right) = \sigma^{2} + \mu^{2}\)

표본 적률: \(m_{1}' = E(X) = \overset{¯}{X}\), \(m_{2}' = E\left( X^{2} \right) = \frac{1}{n}\sum X_{i}^{2}\)

방정식: \(\mu = \overset{¯}{X}\), \(\sigma^{2} + \mu^{2} = \frac{\sum X_{i}^{2}}{n}\)

평균 추정량: \(\overset{\hat{}}{\mu} = \overset{¯}{x}\)

분산 추정량: \(\overset{\hat{}}{\sigma^{2}} = \frac{1}{n}\sum X_{i}^{2} - {\overset{¯}{X}}^{2} = \frac{1}{n}\sum\left( X_{i} - \overset{¯}{X} \right)^{2}\)

【예제 ③】 모집단 \(U(0,\theta)\)으로부터 확률표본 \(\left( X_{1},X_{2},\ldots,X_{n} \right)\)이다. 적률방법으로 추정량 \(\widehat{\theta}\) 구하라.

모집단 적률: \(\mu_{1}' = E(X) = \frac{\theta}{2}\)

표본 적률: \(m_{1}' = \overset{¯}{X}\)

\(\overset{¯}{X} = \frac{\theta}{2}\) 이므로 적률에 의한 추정량은 \(\overset{\hat{}}{\theta} = 2\overset{¯}{X}\)이다.

추정량 \(\overset{\hat{}}{\theta} = 2\overset{¯}{X}\)은 불편 추정량은 (\(E\left( 2\overset{¯}{X} \right) = 2\theta \neq \theta\))아니지만 일치 추정량이다. 【정리】 만약 \(\lim_{n \rightarrow \infty}{V\left( \overset{\hat{}}{\theta} \right)( = 4\frac{\theta^{2}}{12n}) = 0}\)이면 \(\overset{\hat{}}{\theta}\)는 일치 추정량이다.

【예제 ④】 모집단 \(Gamma(\alpha,\beta)\)으로부터 확률표본 \(\left( X_{1},X_{2},\ldots,X_{n} \right)\)이다. 적률방법으로 모수 \(\alpha,\beta\) 추정량을 구하라.

모집단 적률: \(\mu_{1}' = E(X) = \alpha\beta,\mu_{2}' = E\left( X^{2} \right) = \alpha\beta^{2} + (\alpha{\beta)}^{2}\)

표본 적률: \(m_{1}' = E(X) = \overset{¯}{X}\), \(m_{2}' = E\left( X^{2} \right) = \frac{1}{n}\sum X_{i}^{2}\)

방정식: \(\alpha\beta = \overset{¯}{X}\), \(\alpha\beta^{2} + \alpha\beta^{2} = \frac{\sum X_{i}^{2}}{n}\)

추정량: \(\overset{\hat{}}{\alpha} = \frac{n\overset{¯}{X}}{n\sum\left( X_{i} - \overset{¯}{X} \right)^{2}}\), \(\overset{\hat{}}{\beta} = \frac{\sum\left( X_{i} - \overset{¯}{X} \right)^{2}}{n\overset{¯}{X}}\)

불편 추정량은 아니지만 \(\overset{¯}{X}\)는 \(\alpha\beta\)의 일치 추정량이고 \(\frac{1}{n}\sum X_{i}^{2}\)은 \(\alpha\beta^{2} + (\alpha{\beta)}^{2}\)의 일치 추정량이다. 적률에 의해 구한 추정량은 일치 추정량이기는 하지만 불편성 보장은 물론 MVUE라는 보장이 없다. 쉽게 얻을 수 있다는 장점으로 인하여 추정량을 이해하기 위하여 시작점이 된다.

(2) 최대우도 추정량 MLE

개념

최종적으로 최량 추정량, MVUE(minimum variance unbiased estimator 최소분산 불편 추정량)를 구하기 위하여 ⑴Factorial criterion에 의해 충분 통계량을 구하고 ⑵충분 통계량의 함수이면서 불편성을 갖는 추정량을 구하면 Rao-Blackwell 정리에 의해 이것이 MVUE이다. 그러나 불편 추정량을 구하는 것이 그렇게 쉽지만은 않다.

한편, 적률에 의한 추정량은 일치성은 보장하지만 불편성, MVUE는 아닐 가능성이 높다. 이제 MVUE일 가능성이 높은 추정 방법을 소개하고자 한다. 추출된(수집된) 확률표본(데이터)이 어떤 모수 값일 경우 그 값들이 추정될 가능성이 가장 높은가? 이를 최대 우도 추정량이라 한다. 통계추론에서 사용되는 추정량은 대부분 MLE이다.

주머니 속에 공이 3개 들어 있다. 공의 색깔은 하양, 파랑일 수 있다. 그러나 각 몇 개씩 들어 있는지는 모른다고 가정하자. 2개의 공을 뽑아 색을 보고 주머니에 있는 공의 색을 맞춘다고 하자. 공 2개를 뽑았더니 파랑이었다. 그럼? 주머니의 공은?

하얀 공일 확률: 1/3(\(= \binom{2}{2}\binom{1}{0}/\binom{3}{2}\)), 파란 공일 확률: 1(\(= \binom{3}{2}/\binom{3}{2}\)) 파랑 공이 가능성이 높다. 이렇게 모수에 대한 추정량을 구하는 방법이 최대우도 추정법이다.

MLE 구하기

【우도함수】 알려지지 않은 모집단 확률분포함수 \(f(x;\theta),\theta \in \Omega\)에 대한 정보를 얻기 위하여 추출한 크기 \(n\)의 (확률)표본 \(\overline{X} = \left( X_{1},X_{2},\ldots,X_{n} \right)\)의 결합 확률밀도함수를 모수 포함한 함수로 표현한 것을 우도함수 likelihood function 이라 하며 모수의 함수이다.

\(L\left( \theta;x_{1},x_{2},\ldots,x_{n} \right) = L(\theta;\overline{x}) = \prod_{i}^{n}{f(x_{i};}\theta)\)

확률표본(데이터) 결합 확률(표본 데이터가 수집되었다면 어떤 모수 값일 가능성이 가장 높은가)을 최대화 하는 모수 값을 MLE라 한다.

【MLE】 우도함수 최대화 하는 \(\theta\)를 최대우도 maximum likelihood 추정량 이라 한다.

\(\frac{\partial L(\theta)}{\partial\theta} = 0\)을 만족하는 추정량 \(\overset{\hat{}}{\theta}(\overline{x})\)을 \(MLE\) 이라 한다.

【로그 우도함수】 우도 함수는 항상 0보다 크므로 우도함수 최대화 하는 \(\theta\) 계산 ⬄ 로그 우도함수 최대화 하는 \(\theta\) 계산

【예제 ①】 어느 지역의 암 환자 비율 \(p\)을 추정하려고 한다. 모수 \(p\)인 베르누이 확률밀도함수로부터 확률표본을 추출하였다고 하자.

모집단 확률밀도함수 : \(f(x;\theta = p) = p^{x}(1 - p)^{1 - x},x = 0,1\)

우도 함수: \(L(\theta;\overline{x}) = \prod_{i}^{n}{f(x_{i};p)} = \sum_{i}^{n}{p^{x_{i}}(1 - p)^{1 - x_{i}}} = p^{\sum x_{i}}(1 - p)^{n - \sum x_{i}}\)

로그 우도함수: \(l(\theta) = \ln\left( L(\theta) \right) = \sum x_{i}\ln(p) + (n - \sum x_{i})ln(1 - p)\)

MLE: \(\frac{\partial l(\theta)}{\partial\theta} = \sum x_{i}\left( \frac{1}{p} \right) + (n - \sum x_{i})\frac{1}{1 - p}( - 1) = 0\),

그러므로 \(\overset{\hat{}}{p} = \frac{\sum x_{i}}{n}\)이다.

【예제 ②】 빼빼로 중량이 \(N(\mu,\sigma^{2})\)을 따른다고 하자. 중량 평균을 추정하기 위하여 확률표본을 추출하였다고 하였다. 모집단 모수 \(\overline{\theta} = (\mu,\sigma)\)는 2개이나 평균에 관심이 있으므로 \(\mu\)는 목표 모수, 분산 \(\sigma^{2}\)은 불필요 nuisance 모수 이다.

모집단 확률밀도함수: \(f(x;\mu,\sigma) = \frac{1}{2\sqrt{}\pi\sigma}\exp\left( - \frac{(x - \mu)^{2}}{2\sigma^{2}} \right), - \infty < x < \infty\)

로그 우도함수: \(l\left( \mu,\sigma^{2} \right) = \frac{n}{2}\ln(2\pi) - \frac{1}{2}\sum\left( \frac{x_{i} - \mu}{\sigma} \right)^{2}\)

MLE: \(\frac{\partial l(\mu,\sigma)}{\partial\mu} = 0,\frac{\partial l\left( \mu,\sigma^{2} \right)}{\partial\sigma^{2}} = 0\) 그러므로 \(\overset{\hat{}}{\mu} = \overset{¯}{X},{\overset{\hat{}}{\sigma}}^{2} = \frac{\sum\left( x_{i} - \overset{¯}{x} \right)^{2}}{n}\)이다.

【예제 ③】 모집단 확률분포 \(U(0,\theta)\), 확률표본에서 MLE을 구하시오.

모집단 확률밀도함수 : \(f(x;\theta) = \frac{1}{\theta},0 < x < \theta\)

우도함수 : \(L(\theta) = \Pi\left( \frac{1}{\theta} \right)I_{(x_{i},\theta)} = \Pi\left( \frac{1}{\theta} \right)I_{(\max\left\{ x_{i} \right\},\theta)}\)

\(I_{\lbrack a,b\rbrack}\)은 지시 indicator 함수로 \((a < b)\)이면 1, 그렇지 않으면 0이다. 우도함수 최대화 되려면 \(\overset{\hat{}}{\theta} = \max\left\{ x_{i} \right\} = x_{(n)}\)

【예제 ④】 라플라스분포 \(f(x;\theta) = \frac{1}{2}e^{- |x - \theta|}, - \infty < x < \infty, - \infty < \theta < \infty\)을 따르는 확률표본을 이용하여 \(\theta\)에 대한 MLE 구하라.

로그 우도함수: \(l(\theta) = - nln(2) - \sum_{i}^{n}{|x_{i} - \theta|}\)

미분: $ = {i}^{n}{sgn(x{i} - )} = 0,wheresgn(t) = { \begin{array}{r}

1,t < 0 \ 0,t = 0 \ 1,t > 0 \end{array} . $

그러므로 \(\overset{\hat{}}{\theta} = Median\), MLE이다.

【예제 ⑤】 \(N(\mu,1),where\mu > 0\)을 따르는 확률표본을 이용하여 \(\mu\)에 대한 MLE 구하라.

- 로그 우도함수 최대화 하는 MLE \(\overset{\hat{}}{\mu} = \overline{X}\) 이므로 \(\overset{\hat{}}{\mu} = \left\{ \begin{array}{r} \overline{X}if\overline{X} \geq 0 \\ 0if\overline{X} < 0 \end{array} \right.\ \)

【예제 ⑥】 \(B(n,p)\)을 따르는 확률표본을 이용하여 \(n\)에 대한 MLE 구하라(단, \(p\)는 알려져 있음). (적용) 동전의 공정성을 평가하기 위하여 몇 번을 던져야 하나?

우도함수 : \(L\left( k;\overline{x},p \right) = \prod_{i}^{n}{\binom{k}{x_{i}}p^{x_{i}}(1 - p)^{k - x_{i}}}\)

\(k\)에 대한 우도함수 미분은 쉽지 않다. 만약 \(k < x_{(n)}\)이면 \(L\left( k;\overline{x},p \right) = 0\) 이므로 다음 조건을 만족하는 \(k \geq x_{(n)}\)이 MLE이다.

\(\frac{L\left( k;\overline{x},p \right)}{L\left( k - 1;\overline{x},p \right)} \geq 1,\frac{L\left( k + 1;\overline{x},p \right)}{L\left( k;\overline{x},p \right)} < 1\).

그러므로 최대화 조건은 다음과 같다.\(\left( k(1 - p) \right)^{n} \geq \prod_{1}^{n}\left( k - x_{i} \right)and\left( (k + 1)(1 - p) \right)^{n} \geq \prod_{1}^{n}{(k + 1 - x_{i})}\)이다. 결론적으로 \((1 - p)^{n} = \overset{n}{\prod_{i = 1}}(1 - x_{i}z)\). 구간 \(0 \leq z \leq 1/\max_{i}x_{i}\) 범위 내에서 MLE 구하면 \(\widehat{k} = \lfloor 1/\widehat{z}\rfloor\) 소숫점 버리고 내림한 값이다.

MLE 성질

【invariance property】 \(f(x;\theta),\theta \in \Omega\)을 따르는 확률표본으로부터 \(\overset{\hat{}}{\theta}\)은 MLE, \(\theta \rightarrow \tau(\theta)\) 일대일 맵핑이라면 \(\tau(\theta)\) MLE은 \(\tau\left( \overset{\hat{}}{\theta} \right)\)이다.

【예제 ①】 \(N\left( \mu,\sigma^{2} \right)\)에서 \(\overline{\theta} = (\mu,\sigma^{2})\) MLE는 \(\overset{\hat{}}{\mu} = \overset{¯}{X},{\overset{\hat{}}{\sigma}}^{2} = \frac{\sum\left( x_{i} - \overset{¯}{x} \right)^{2}}{n}\).

invariance property에 의해 표준편차 \(\sigma = \sqrt{\sigma^{2}}(\tau(\theta))\) MLE는 \(\overset{\hat{}}{\sigma} = \sqrt{\frac{\sum\left( x_{i} - \overset{¯}{x} \right)^{2}}{n}}\)이다.

【예제 ②】 \(B(p)\)에서 확률표본 \((X_{1},X_{2},\ldots,X_{n})\)이다. \(V(X)\)의 MLE 구하라.

\(V(X) = p(1 - p)\)이고 모수 \(p\)에 대한 MLE은 \(\overset{\hat{}}{p} = \frac{\sum X_{i}}{n}\) 이므로 분산의 MLE는 \(\overset{\hat{}}{V(X)} = \frac{\sum X_{i}}{n}(1 - \frac{\sum X_{i}}{n})\)이다.

【정의】 모수 \(\theta\)에 대한 MLE \({\overset{\hat{}}{\theta}}_{mle}\)은 일치 추정량이다.

(3) 베이즈 추정량

베이지안 접근법은 통계학에 대한 고전적인 접근법과 근본적으로 다른데 고전적인 접근법에서는 모수 \(\theta\)가 알려지지 않지만 고정된 값으로 간주된다. 모수 \(\theta\)에 대한 정보는 확률표본 \(\overline{X} = \left( X_{1},X_{2},\ldots,X_{n} \right)\)을 추출한 후 계산된 통계량을 기초하여 얻어진다.

베이지안 접근법에서는 모수 \(\theta\)는 확률변수로서의 변동성을 갖는 양으로 간주되며 이를 사전 확률밀도함수라 한다. 이는 분석자의 믿음에 기반한 주관적인 분포로서 데이터가 관찰되기 전에 정의하고 그런 다음 모수 \(\theta\)인 모집단에서 표본을 추출하고 이 표본 정보를 사용하여 사전 분포를 업데이트한다. 이 업데이트된 사전 분포를 사후 분포라고 하고 이러한 업데이트는 베이즈 정리를 사용하여 수행한다.

【사후확률】 \(\pi(\theta)\) 모수 사전 prior 확률밀도함수, \(L(\theta;\overline{x})\)을 우도 함수이면 확률표본 \(\overline{x} = \left( x_{1},x_{2},\ldots,x_{n} \right)\)이 주어진 경우 모수에 대한 조건부 확률밀도함수를 사후 posterior 확률밀도함수라 한다.

\(\pi\left( \theta \middle| \overline{x} \right) = \frac{\pi(\theta)L(\theta;\overline{x})}{m(\overline{x})} \propto \pi(\theta)L(\theta;\overline{x}),wherem\left( \overline{x} \right) = \int\pi(\theta)L\left( \theta;\overline{x} \right)d\theta\)

【bayes estimator 베이지안 추정량 정의】

최소 squared error loss function(제곱 오차 손실함수) \(Loss\left( \theta,\overset{\hat{}}{\theta} \right) = \left( \theta - \overset{\hat{}}{\theta} \right)^{2}\): 사후 확률함수 평균

최소 absolute error loss function(절대 오차 손실함수) \(Loss\left( \theta,\overset{\hat{}}{\theta} \right) = |\theta - \overset{\hat{}}{\theta}|\): 사후 확률함수 중앙값

【예제 ①】 \(B(p)\)에서 추출한 확률표본 \(\overline{X} = \left( X_{1},X_{2},\ldots,X_{n} \right)\)을 이용하여 베이즈 추정량 구하라.

우도함수 : \(L\left( p;\overline{x} \right) = \binom{n}{y}p^{y}(1 - p)^{n - y}wherey = \sum_{i}^{n}x_{i}\)

사전확률 : (1) uniform prior \(\pi(p) \sim U(0,1)\), (2) conjugate prior \(\pi(p) \sim Beta(\alpha,\beta)\)

conjugate prior: 사후 확률밀도함수와 동일한 분포를 갖는 사전 확률밀도함수를 conjugate prior라 한다. 비율의 사후 확률밀도함수가 베타분포 이므로 사전 확률밀도함수를 베타분포이면 이를 conjugate prior라 한다.

uniform prior 사후확률: \(\pi\left( p \middle| \overline{x} \right) \propto 1_{(0,1)}^{p}\binom{n}{y}p^{y}(1 - p)^{n - y} \sim Beta(y + 1,n - y + 1)\)

conjugate prior 사후확률: \(\pi\left( p \middle| \overline{x} \right) \propto Beta(\alpha,\beta)\binom{n}{y}p^{y}(1 - p)^{n - y} \sim Beta(\alpha + y,\beta + n - y)\)

베이즈 추정량 (제곱 오차 손실 함수 적용): \(\overset{\hat{}}{p} = \frac{y + 1}{(n + 2)}\)(uniform prior), \(\overset{\hat{}}{p} = \frac{\alpha + y}{(n + \alpha + \beta)}\)(conjugate prior)

【예제 ②】 \(N\left( \theta,\sigma^{2} \right)\)에서 추출한 확률표본 \(\overline{X} = \left( X_{1},X_{2},\ldots,X_{n} \right)\)을 이용하여 \(\left( \theta,\sigma^{2} \right)\)베이즈 추정량 구하라.

Conjugate 사전 확률밀도 함수: \(\pi(\theta) \sim N(\mu,\tau^{2})\)

사후 확률밀도함수: \(\pi\left( \theta \middle| \overline{x} \right) \sim N(\frac{\tau^{2}}{\tau^{2} + \sigma^{2}}\overline{x} + \frac{\sigma^{2}}{\tau^{2} + \sigma^{2}}\mu,\frac{\sigma^{2}\tau^{2}}{\tau^{2} + \sigma^{2}})\)

제곱 오차 손실함수 최소화 베이즈 추정량: \(\overset{\hat{}}{\theta} = \frac{\tau^{2}}{\tau^{2} + \sigma^{2}}\overline{x} + \frac{\sigma^{2}}{\tau^{2} + \sigma^{2}}\mu\).

3. 추정량 평가

앞 절에서는 모수의 점추정량을 구하는 여러 가지 합리적인 방법들을 소개하였다. 그러나 실제 통계 분석에서는 동일한 상황에 대해 서로 다른 추정 방법을 적용할 수 있는 경우가 많다. 따라서 여러 추정량 후보 중에서 어떤 추정량을 선택할 것인지 결정해야 하는 중요한 과제가 남는다.

점추정은 흔히 과녁에 화살을 쏘는 것에 비유된다. 모집단으로부터 확률표본을 얻고, 이를 바탕으로 모수를 추정하는 것은 마치 과녁을 향해 한 발의 화살을 쏘는 것과 같다. 과연 이 화살은 과녁 한가운데, 즉 bull-eye에 명중했을까? 만약 단 한 번의 시도에서 bull-eye에 명중했다고 해도, 그 사람을 진정한 명궁이라 부를 수 있을까? 아마도 아닐 것이다. 동일한 조건에서 여러 차례 화살을 쏘아, 일관되게 bull-eye에 가까운 결과를 보여줘야 비로소 실력을 인정받을 수 있을 것이다.

이와 마찬가지로, 한 번의 점추정으로는 그 추정치가 얼마나 좋은지를 판단할 수 없다. 좋은 추정량인지 판단하려면, 동일한 절차를 여러 번 반복하여 얻은 추정치들의 분포를 살펴보아야 한다. 즉, 추정치들의 평균과 분산, 그리고 그 특성을 분석함으로써 해당 추정량의 성능을 평가할 수 있다.

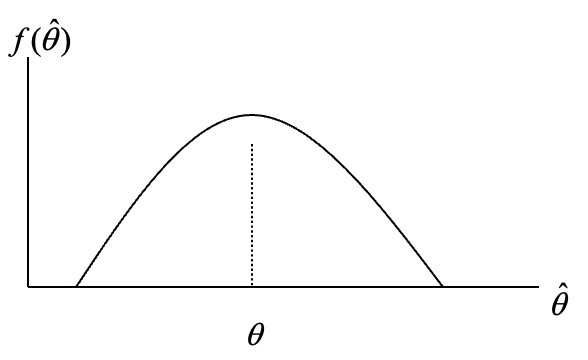

목표 모수 \(\theta\)에 대한 추정량 \(\overset{\hat{}}{\theta}\)을 여러 번 얻는다면(\(\overset{\hat{}}{\theta}\) 확률밀도함수, \(f(\overset{\hat{}}{\theta})\),샘플링 분포도 얻을 수 있음) 그 추정량은 모수 \(\theta\)을 중심으로 흩어져 있을 것이다. 모수 부근에 있을 가능성은 높고 멀어질수록 가능성은 떨어질 것이다.

(1) 평균제곱오차

【MSE】 추정량 \(W\)와 모수 \(\theta\)에 대해, 평균제곱오차(Mean Squared Error, MSE)는 \(MSE(W) = E_{\theta}(W - \theta)^{2}\)로 정의된다.

평균 절대오차 \(E_{\theta}(|W - \theta|)\))도 점추정량 성능 척도의 대안이 될 수 있으나, MSE는 다음과 같은 두 가지 강점을 가진다.

수학적으로 다루기 쉬움

분산과 편향이라는 명확한 해석 가능

\[MSE = E_{\theta}(W - \theta)^{2} = {Var}_{\theta}(W) + (E_{\theta}W - \theta)^{2}\]

\({Var}_{\theta}(W)\): 추정량 \(W\)의 분산(추정분산) - 추정량의 변동성

\((E_{\theta}W - \theta)^{2}\): 추정량 \(W\)의 편향 bias의 제곱 - 추정량이 모수에 얼마나 가까운지

【편향】 추정량 \(W\) 의 편향은 \({Bias}_{\theta}(W) = E_{\theta}W - \theta\) 으로 정의된다.

만약 \({Bias}_{\theta}(W) = 0\)이면, 추정량 W는 불편 unbiased 추정량이라 한다. 이는 모든 \(\theta\)에 대해 \(E_{\theta}W = \theta\)를 만족한다는 뜻이다. 불편 추정량인 경우 \(MSE_{\theta}(W) = V_{\theta}(W)\)이다.

【예제 ①】 \(f(x;\theta) \sim N(\mu,\sigma^{2})\)에서 표본크기 \(n\)인 확률표본을 추출하였다. MLE 추정량 \(\overline{X},S^{2}\)이 불편 추정량 인지 보이고 MSE 구하라.

\(E(\overline{X}) = \mu,E(S^{2}) = \sigma^{2}\)

\(MSE(\overline{X}) = E(\overline{X} - \mu)^{2} = Var(\overline{X}) = \frac{\sigma^{2}}{n}\)

\(MSE(S^{2}) = E(S^{2} - \sigma^{2})^{2} = Var(S^{2}) = \frac{2\sigma^{4}}{n - 1}\)

【예제 ②】 \(f(x;\theta) \sim U(\theta,\theta + 1)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 추정량 \(\overset{¯}{X}\)가 편의 추정량 임을 보이고 MSE 구하라.

\(E(X) = \frac{2\theta + 1}{2},V(X) = \frac{1}{12}\).

편의: \(B\left( \overline{x} \right) = \frac{2\theta + 1}{2} - \theta = \frac{1}{2}\).

추정분산 \(V\left( \overline{x} \right) = \frac{1}{12n}\) 이므로 \(MSE\left( \overline{x} \right) = \frac{1}{12n} + \frac{1}{4}\)이다.

【예제 ③】 \(f(x;\theta) = \frac{1}{\theta}e^{- x/\theta},0 < x\) 에서 표본크기 3인 확률표본 \((X_{1},X_{2},X_{3})\) 추출하였다. 4개 추정량 중 MSE가 가장 작은 것은?

\((1){\overset{\hat{}}{\theta}}_{1} = X_{1}(2){\overset{\hat{}}{\theta}}_{2} = \frac{X_{1} + X_{2}}{2}(3){\overset{\hat{}}{\theta}}_{3} = \frac{X_{1} + 2X_{2}}{3}(4){\overset{\hat{}}{\theta}}_{4} = \frac{X_{1} + X_{2} + X_{3}}{3}\)

\(E(X) = \theta,V(X) = \theta^{2}\)이므로, \(E\left( {\overset{\hat{}}{\theta}}_{1} \right) = \theta,E\left( {\overset{\hat{}}{\theta}}_{2} \right) = \theta,E\left( {\overset{\hat{}}{\theta}}_{3} \right) = \theta,E\left( {\overset{\hat{}}{\theta}}_{4} \right) = \theta\) 이므로 모두 불편 추정량 이다.

\(MSE\left( {\overset{\hat{}}{\theta}}_{1} \right) = V\left( {\overset{\hat{}}{\theta}}_{1} \right) = \theta^{2}\), \(MSE\left( {\overset{\hat{}}{\theta}}_{2} \right) = \frac{\theta^{2}}{2}\), \(MSE\left( {\overset{\hat{}}{\theta}}_{3} \right) = \frac{5\theta^{2}}{9}\), \(MSE\left( {\overset{\hat{}}{\theta}}_{4} \right) = \frac{\theta^{2}}{3}\), 4번째 추정량 MSE가 최소

【예제 ④】 \(f(x;p) = p^{x}(1 - p)^{1 - x},x = 0,1\) 베르누이 분포에서 표본크기 n인 확률표본을 추출하였다. MLE 추정량과 베이지 추정량의 MLE을 구하시오.

모집단 평균 및 분산: \(E(X) = p,V(X) = p(1 - p)\)

MLE: \(\widehat{p} = \frac{\sum X_{i}}{n}\), \(MSE = E_{p}(\widehat{p} - p)^{2} = {Var}_{p}(\overline{X}) = \frac{p(1 - p)}{n}\)

베이지 추정량: \({\widehat{p}}_{B} = \frac{Y + \alpha}{\alpha + \beta + n}\)

\[E_{p}({\widehat{p}}_{B} - p)^{2} = {Var}_{p}({\widehat{p}}_{B}) + ({Bias}_{p}({\widehat{p}}_{B}))^{2}\]

\[= {Var}_{p}\left( \frac{Y + \alpha}{\alpha + \beta + n} \right) + \left( E_{p}\left( \frac{Y + \alpha}{\alpha + \beta + n} \right) - p \right)^{2} = \frac{np(1 - p)}{(\alpha + \beta + n)^{2}} + \left( \frac{np + \alpha}{\alpha + \beta + n} - p \right)^{2}\]

(2) 상대효율

앞에서 살펴보았듯이 모수 \(\theta\)에 대한 불편 추정량은 무수히 많이 존재한다. 두 불편 추정량 \({\overset{\hat{}}{\theta}}_{1},{\overset{\hat{}}{\theta}}_{2}\)을 생각해 보자. 만약 \({V(\overset{\hat{}}{\theta}}_{1}) \leq V({\overset{\hat{}}{\theta}}_{2})\)라면 \({\overset{\hat{}}{\theta}}_{1}\)은 \({\overset{\hat{}}{\theta}}_{2}\)에 비해 상대적으로 효율적 efficient 이라고 정의한다.

【상대효율】 \({eff(\overset{\hat{}}{\theta}}_{1},{\overset{\hat{}}{\theta}}_{2}) = \frac{{V(\overset{\hat{}}{\theta}}_{2})}{V({\overset{\hat{}}{\theta}}_{1})}\), 추정량 \({\overset{\hat{}}{\theta}}_{2}\)에 대한 \({\overset{\hat{}}{\theta}}_{1}\)의 상대효율이라 한다.

\({\overset{\hat{}}{\theta}}_{1},{\overset{\hat{}}{\theta}}_{2}\)가 불편 추정량이면 추정 분산과 추정 평균제곱오차은 동일하므로 추정 분산이 적은 추정량이 (즉 효율적인 추정량) 좋은 추정량이다.

【예제 ①】 \(f(x;\theta) \sim U(0,\theta)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. \(({\overset{\hat{}}{\theta}}_{1} = 2\overline{X},{\overset{\hat{}}{\theta}}_{2} = \frac{n + 1}{n}X_{(n)})\) 추정량이 불편 추정량임을 보이고 상대효율을 구하라.

\(E(X) = \frac{\theta}{2},V(\theta) = \frac{\theta^{2}}{12}\). \(E\left( {\overset{\hat{}}{\theta}}_{1} \right) = E\left( 2\overline{X} \right) = 2\frac{\theta}{2} = \theta\) 불편 추정량이다.

\(V\left( {\overset{\hat{}}{\theta}}_{1} \right) = V\left( 2\overline{X} \right) = 4\frac{\theta^{2}}{12n} = \frac{\theta^{2}}{3n}\).

순서 통계량 \(Y = X_{(n)}\) 확률밀도함수: \(f(y) = n\left( \frac{y}{\theta} \right)^{n - 1}\left( \frac{1}{\theta} \right),0 < y < \theta\).

\(E(Y) = \frac{n}{n + 1}\theta,V(Y) = \left( \frac{n}{n + 2} - \left( \frac{n}{n + 2} \right)^{2} \right)\theta^{2}\).

\(E\left( {\overset{\hat{}}{\theta}}_{2} \right) = E\left( \frac{n + 1}{n}X_{(n)} \right) = \frac{n + 1}{n}\frac{n}{n + 1}\theta = \theta\) 불편 추정량이다. .

\(V\left( {\overset{\hat{}}{\theta}}_{2} \right) = \frac{1}{n(n + 2)}\theta^{2}\).

\({eff(\overset{\hat{}}{\theta}}_{1},{\overset{\hat{}}{\theta}}_{2}) = \frac{{V(\overset{\hat{}}{\theta}}_{2})}{V({\overset{\hat{}}{\theta}}_{1})} = \frac{3}{n + 2}\) 이므로 \(n \geq 1\) 이면 \({\overset{\hat{}}{\theta}}_{1}\)이 \({\overset{\hat{}}{\theta}}_{2}\)에 비해 상대적으로 효율적이다.

【예제 ②】 \(f(x;\theta) = \frac{1}{\theta}e^{- x/\theta},0 < x\)에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였다. \(({\overset{\hat{}}{\theta}}_{1} = \frac{X_{1} + X_{2}}{2},{\overset{\hat{}}{\theta}}_{2} = {\overline{X}}_{n})\) 불편 추정량임을 보이고 상대효율을 구하라.

\(E(X) = \theta,V(\theta) = \theta^{2}\)

\(E\left( {\overset{\hat{}}{\theta}}_{1} \right) = E\left( \frac{X_{1} + X_{2}}{2} \right) = \theta\) 불편 추정량이다. \(V\left( {\overset{\hat{}}{\theta}}_{1} \right) = V\left( \frac{X_{1} + X_{2}}{2} \right) = \frac{\theta^{2}}{2}\)

\(E\left( {\overset{\hat{}}{\theta}}_{2} \right) = E\left( \frac{X_{1} + X_{2} + \ldots + X_{n}}{n} \right) = \theta\) 불편 추정량이다 \(V\left( {\overset{\hat{}}{\theta}}_{1} \right) = V\left( {\overline{X}}_{n} \right) = \frac{\theta^{2}}{n}\)

\({eff(\overset{\hat{}}{\theta}}_{1},{\overset{\hat{}}{\theta}}_{2}) = \frac{{V(\overset{\hat{}}{\theta}}_{2})}{V({\overset{\hat{}}{\theta}}_{1})} = \frac{n}{2}\) 이므로 \(n \geq 2\) 이면 \({\overset{\hat{}}{\theta}}_{2}\)이 \({\overset{\hat{}}{\theta}}_{1}\)에 비해 상대적으로 효율적이다.

(3) 최량 불편 추정량

최소 MSE을 갖는 추정량을 최량 추정량으로 정의하였는데 실제 MSE을 최소화 하는 추정량을 구하는 것은 쉽지 않거나(수학적 접근 매우 어려움) 실제 ”최고의 MSE 추정량”은 존재하지 않는다. 이는 후보 추정량의 범위가 너무 넓기 때문인데, \(\widehat{\theta} = 17\)은 \(\theta = 17\)일 때 MSE가 최솟값이지만 다른 값에서는 매우 나쁜 추정량이다.

불편추정량으로 범위를 제한하면 후보 추정량의 범위를 불편추정량으로 제한한다. MSE 비교는 단순히 분산 비교로 귀결되므로 추정분산이 더 작은 불편추정량을 선택하면 된다.

【정의】 추정량 \(W^{*}\)가 다음 조건을 만족하면 \(\tau(\theta)\)에 대한 최량 불편추정량 best unbiased estimator 이라 한다.

모든 \(\theta\)에 대해 \(E_{\theta}W^{*} = \tau(\theta)\)

임의의 다른 추정량 \(W\)에 대해 \(Var\theta(W^{*}) \leq Var\theta(W)\text{for all}\theta\)

【예제 ①】 \(f(x;\theta) \sim B(n,p)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 다음 2개 추정량에 대하여 (1) 불편 추정량인지 보이고 (2) MSE을 비교하라. \((1){\overset{\hat{}}{p}}_{1} = \frac{\sum X_{i}}{n}(2){\overset{\hat{}}{p}}_{2} = \frac{\sum X_{i} + 1}{n + 2}\).

\(E(X) = p,V(X) = p(1 - p)\).

\(E\left( \frac{\sum X_{i}}{n} \right) = p\) 이므로 \({\overset{\hat{}}{p}}_{1}\)는 불편 추정량 이다.

\(E\left( \frac{\sum X_{i} + 1}{n + 2} \right) = \frac{p + 1}{n + 2}\) 이므로 \({\overset{\hat{}}{p}}_{2}\)는 불편 추정량 아니다.

\(B\left( {\overset{\hat{}}{p}}_{2} \right) = \frac{1 - np - p}{n + 2}\).

\(MSE\left( {\overset{\hat{}}{p}}_{1} \right) = MSE\left( \frac{\sum X_{i}}{n} \right) = V\left( \frac{\sum X_{i}}{n} \right) = \frac{p(1 - p)}{n}\)

\(MSE\left( {\overset{\hat{}}{p}}_{2} \right) = MSE\left( \frac{\sum X_{i} + 1}{n + 2} \right) = V\left( \frac{\sum X_{i} + 1}{n + 2} \right) + B^{2}\left( \frac{\sum X_{i} + 1}{n + 2} \right) = \frac{np(1 - p)}{(n + 2)^{2}} + \frac{(1 - np - p)^{2}}{(n + 2)^{2}}\)

그러므로 \(MSE\left( {\overset{\hat{}}{p}}_{1} \right) > MSE\left( {\overset{\hat{}}{p}}_{2} \right)for0 < p < 1\).

【예제 ②】 \(f(x;\theta) \sim Poisson(\lambda)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 포아송 분포는 평균, 분산이 동일하므로 표본평균(\(\overline{x}\)), 표본분산(\(S^{2}\)) 모두 불편 추정량이다. 어느 추정량을 사용할 것인가? 추정 분산이 적은 통계량을 사용해야 한다.

표본평균 추정분산: \(V\left( \overset{¯}{x} \right) = \frac{\lambda}{n}\).

표본분산 추정분산: \(\frac{(n - 1)S^{2}}{\sigma^{2}( = \lambda)} \sim \chi^{2}(n - 1)\) 이므로 \(V(S^{2}) = \frac{2\lambda^{2}}{n - 1}\)이다.

\(V(\overline{X}) \leq V(S^{2})\)

최량 불편추정량을 찾는 과정은 매우 복잡하다. 만약 어떤 분포 \(f(x|\theta)\)에 대해 모수 \(\tau(\theta)\)의 불편추정량의 분산에 대한 하한 \(B(\theta)\)를 설정할 수 있다면,\({Var}_{\theta}(W) = B(\theta)\)를 만족하는 추정량을 찾으면 최량 불편추정량을 찾은 것이 된다.

【Cramér–Rao Lower Bound, CRLB】 확률밀도함수 \(f(x|\theta)\)의 확률표본으로부터의 추정량 \(W(\mathbf{X}) = W(X_{1},\ldots,X_{n})\)는 다음을 만족한다면, \({Var}_{\theta}(W(\mathbf{X})) \geq \frac{\left( \frac{d}{d\theta}E_{\theta}W(\mathbf{X}) \right)^{2}}{nE_{\theta}\left( \left( \frac{\partial}{\partial\theta}\log f(\mathbf{X}|\theta) \right)^{2} \right)}\)

\(\frac{d}{d\theta}E_{\theta}W(\mathbf{X}) = \int_{x}\frac{\partial}{\partial\theta}\lbrack W(x)f(x|\theta)\rbrack dx\)

\({Var}_{\theta}(W(\mathbf{X})) < \infty\)

【Fisher Information】 확률밀도함수 \(f(x|\theta)\)가 지수족을 따르다면 \(E_{\theta}\left( \left( \frac{\partial}{\partial\theta}\log f(X|\theta) \right)^{2} \right) = - E_{\theta}\left( \frac{\partial^{2}}{\partial\theta^{2}}\log f(X|\theta) \right)\)

【예제 ② 계속】 \(f(x;\theta) \sim Poisson(\lambda)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 모수 \(\lambda\)에 대한 추정량의 분산 그레머 라오 하한을 구하시오.

포아송분포는 지수족이므로 Fisher Information은 다음과 같다.

\(E_{\lambda}\left( \left( \frac{\partial}{\partial\lambda}\log\overset{n}{\prod_{i = 1}}f(X_{i}|\lambda) \right)^{2} \right) = - nE_{\lambda}\left( \frac{\partial^{2}}{\partial\lambda^{2}}\log f(X|\lambda) \right)\)

\(= - nE_{\lambda}\left( \frac{\partial^{2}}{\partial\lambda^{2}}\log\left( \frac{e^{- \lambda}\lambda^{X}}{X!} \right) \right) = - nE_{\lambda}\left( \frac{\partial^{2}}{\partial\lambda^{2}}\left( - \lambda + X\log\lambda - \log X! \right) \right) = \frac{n}{\lambda}\)

\(V_{\lambda}(\overline{X}) = \frac{\lambda}{n}\)이므로 표본평균이 크레머 라오 하한을 보장한다.

【예제 ③】 \(f(x;\theta) \sim N(\mu,\sigma^{2})\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 모수 \(\sigma^{2}\)에 대한 추정량의 분산 그레머 라오 하한을 구하시오.

정규분포는 지수족이므로 \[\frac{\partial^{2}}{\partial(\sigma^{2})^{2}}\log\left( \frac{1}{(2\pi\sigma^{2})^{\frac{1}{2}}}e^{- (1/2)(x - \mu)^{2}/\sigma^{2}} \right) = \frac{1}{2\sigma^{4}} - \frac{(x - \mu)^{2}}{\sigma^{6}}\] \[- E\left( \frac{\partial^{2}}{\partial(\sigma^{2})^{2}}\log f(X|\mu,\sigma^{2}) \right) = - E\left( \frac{1}{2\sigma^{4}} - \frac{(X - \mu)^{2}}{\sigma^{6}} \right) = \frac{1}{2\sigma^{4}}\]

표본분산의 추정분산은 \(Var(S^{2} \mid \mu,\sigma^{2}) = \frac{2\sigma^{4}}{n - 1}\)이므로 표본분산은 그레머 라오 하한을 만족하지 못한다.

4. Rao balckwell 정리 & MVUE

【MVUE 정의】 \(f(x;\theta)\) 에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였고 \(T(\overline{x})\)은 모수 \(\theta\)의 충분 통계량이다. 만약 \(T(\overline{x})\) 불편 추정량이고 다른 불편 추정량의 추정 분산보다 적은 추정 분산을 가진다면 \(T(\overline{x})\)를 최소분산 불편 추정량 minimum variance unbiased estimator 이라 한다.

충분 통계량은 모수에 대한 좋은 추정량을 발견하는데 주요 역할을 한다. 추정량 \(\widehat{\theta}\)을 모수 \(\theta\)의 불편 추정량, 통계량 \(U\)을 모수 \(\theta\)에 대한 충분 통계량이라 하자. 불편 추정량인 충분 통계량 함수는 불편 추정량 중 최소 분산을 갖는다. 만약 최소 분산을 갖는 불편 추정량을 찾는 것은 충분 통계량의 함수인 추정량에 한정하며 된다. 이에 관련된 이론이 Rao-Blackwell 정리라 한다.

【rao-blackwell theorem】 추정량 \(\overset{\hat{}}{\theta}\)는 모수 \(\theta\)의 불편 추정량이고 추정 분산을 \(V(\overset{\hat{}}{\theta})\)이라 하자. 만약 통계량 \(U\)을 모수 \(\theta\)에 대한 충분 통계량이라 하면 \(E(\overset{\hat{}}{\theta}|U)\)은 불편 추정량이고 불편 추정량 중 최소 분산을 갖는다.

\(X_{1},X_{2}\) 확률변수에 대하여 (1) \(E\left( X_{2} \right) = E(E\left( X_{2}|X_{1} \right))\) (2) \(V\left( X_{2} \right) \geq V(E\left( X_{2}|X_{1} \right))\)

\(X_{1}\)=모수 \(\theta\) 충분 통계량 \(U\), \(X_{2}\)=모수 \(\theta\) 불편 통계량 \(\overset{\hat{}}{\theta}\)이라 하자.

= \(E\left( \overset{\hat{}}{\theta} \right) = E(E\left( \overset{\hat{}}{\theta}|U \right))\) 이므로 \(E(\overset{\hat{}}{\theta}|U)\) 불편 추정량이다.

- \(V\left( \overset{\hat{}}{\theta} \right) \geq V(E(\overset{\hat{}}{\theta}|U))\) 이므로 불편 추정량이면서 이전보다 추정분산이 적은 추정량을 얻는다.

R-B 정리는 최소분산을 갖는 불편 추정량은 충분 통계량으로 만들어질 수 있다. 만약 우리가 불편 추정량을 갖고 있다면 R-B 정리를 이용하여 이 불편 추정량을 향상 시킬 수 있다. 이렇게 얻는 추정량에 R-B 정리를 반복 적용하면 된다. 그러나 만약 동일한 충분 통계량을 사용한다면 더 이상 나아지는 것도 없다.

\({\overset{\hat{}}{\theta}}^{*} = E(\overset{\hat{}}{\theta}|U)\)을 새로 얻은 불편 추정량이라 하자. \(E\left( {\overset{\hat{}}{\theta}}^{*} \middle| U \right) = {\overset{\hat{}}{\theta}}^{*}\) 이므로 충분 통계량은 수없이 많다. 그럼 어떤 충분 통계량을 시작점으로 하여 R-B 정리에 사용될까? Factorization criterion이 가장 좋은 충분 통계량을 얻게 한다. 가장 좋은 통계량이란 데이터(확률표본)에 있는 모수에 대한 정보를 가장 잘(best) 요약한 것을 의미하며 이를 Minimal 충분 통계량이라 한다.

【정리】 \(f(x;\theta)\) 에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였고 \(T(\overline{x})\)을 모수 \(\theta\)의 충분 통계량이라 하자. 또 다른 확률표본 \((Y_{1},Y_{2},\ldots,Y_{n})\)에 대하여 \(\frac{L(x_{1},x_{2},\ldots,x_{n};\theta)}{L(y_{1},y_{2},\ldots,y_{n};\theta)}\)가 모수 \(\theta\)의 함수가 성립한다. ⬄ (필요 충분 조건) \(T\left( \overline{x} \right) = T(\overline{y})\). 그리고 \(T(\overline{x})\)을 최소 minimal 충분 통계량이라 한다.

일반적으로 Factorization criterion에서 얻은 충분 통계량과 Minimal 충분 통계량은 같다. 이런 통계량이 갖는 성질을 Completeness(완비성)라 한다.

【ancillary statistics】 모수 \(\theta\)에 의존하지 않는 통계량 \(S(\overline{x})\)을 보조 ancillary 통계량이라 한다.확률 분포의 모수에 관련된 정보가 아닌 추가적인 정보를 제공하는 통계량을 나타내고 모수 추정이나 가설 검정과 같은 통계적 추론에서 사용되는데, 주로 추정된 모수들의 분포나 특성을 이해하고 분석하는 데 활용된다.

【예제】 \(f(x;\theta) \sim U(\theta,\theta + 1)\)에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였다. 통계량 \(R = x_{(n)} - x_{(1)}\)의 확률밀도함수가 모수 \(\theta\)에 의존하지 않으므로 보조 통계량이다.

【예제】 \(f(x;\theta) \sim B(\theta = p)\)에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였다. 충분 통계량 \(\sum X_{i}\)의 확률밀도함수는 \(B(np,np(1 - p))\)로 모수 \(\theta = p\)에 의존하므로 보조 통계량은 아니다. 그러나 \(\frac{\sum X_{i} - np}{\sqrt{np(1 - p)}}\) 확률밀도함수는 표준정규분포(\(N(0,1)\))에 근사하므로 모수에 의존하지 않아 보조 통계량이다. 다음 장에서 이를 검정 통계량이라 한다.

【완비성 completeness】 충분 통계량 \(T\left( \overline{x} \right) \sim f(t;\theta)\)을 갖는다고 하자. 만약 \(E_{\theta}\left( g(T) \right) = 0forall\theta\)가 \(P_{\theta}\left( g(T) = 0 \right) = 1forall\theta\)을 포함하면 \(T\left( \overline{x} \right)\)는 완비 통계량이다.

【예제】 \(f(x;\theta) \sim B(\theta = p)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 충분 통계량 \(\sum X_{i}\)은 완비 통계량임을 보이시오.

\(T = \sum X_{i} \sim B(n,p)\) 이다.

\(0 = E_{p}\left( g(T) \right) = \sum_{t}^{n}{g(t)\binom{n}{t}p^{t}(1 - p)^{n - t} = (1 - p)^{n}}\sum_{t}^{n}{g(t)\binom{n}{t}{(\frac{p}{1 - p})}^{t}forall0 < p < 1}\)

\(0 = \sum_{t}^{n}{g(t)\binom{n}{t}{(\frac{p}{1 - p})}^{t}}\) 이 조건이 만족하기 위해서는 \(P_{\theta}\left( g(T) = 0 \right) = 1\) 이므로 완비 통계량이다.

【예제】 \(f(x;\theta) \sim U(0,\theta)\)에서 표본크기 \(n\)인 확률표본 \((X_{1},X_{2},\ldots,X_{n})\) 추출하였다. 충분 통계량 \({T = x}_{(n)}\)은 완비 통계량이다.

\(T \sim f(t;\theta) = nt^{n - 1}\theta^{- n},0 < t < \theta\) 이다. \(E_{\theta}\left( g(T) \right)\)은 모수 \(\theta\)의 함수이고 상수이므로 \(E_{p}\left( g(T) \right) = 0\)을 보이는 것은 \({\frac{\partial}{\partial\theta}E}_{\theta}\left( g(T) \right) = 0\)을 보이는 것은 동일하다.

\({0 = \frac{\partial}{\partial\theta}E}_{\theta}\left( g(T) \right) = \frac{\partial}{\partial\theta}\int_{0}^{\theta}{g(t)}nt^{n - 1}\theta^{- n}dt = \theta^{- 1}ng(\theta)\)

\(\theta^{- 1}n \neq 0\) 이므로 \(g(\theta) = 0\)이어야 한다. 그러므로 \({T = x}_{(n)}\) 완비 통계량이다.

【basu theorem】 최소 충분 통계량이고 완비 통계량 \(T\left( \overline{x} \right)\)는 다른 모든 보조 통계량과 독립이다.

【정리】 완비 통계량 \(T\left( \overline{x} \right)\)는 최소 충분 통계량이다.

⑴ Factorization에 의해 충분 통계량 \(U\)을 구하고 (2) \(U\) 확률밀도함수의 완비성을 보이고 (3) 완비 충분 통계량 \(U\)의 함수로 된 불편 추정량을 얻으면 이것이 Rao-Blackwell 정리에 의하여 MVUE가 된다.

【lehmann and scheffe theorem】 \(f(x;\theta),\theta \in \Omega\) 에서 표본크기 \(n\)인 확률표본을 추출하였고 \(T(x_{1},x_{2},\ldots,x_{n})\)은 모수 \(\theta\)의 충분 통계량이라 하자. \(T(\overline{x})\)의 확률밀도함수 \(f(t;\theta)\)가 완비성을 갖는다면 불편성을 갖는 \(T(\overline{x})\) 함수, \(g(T\left( \overline{x} \right),E(g\left( T\left( \overline{x} \right) \right) = \theta)\)는 유일 최소분산불편 추정량(MVUE)이다.

【정리】 \(f(x;\theta)\) 에서 표본크기 \(n\)인 확률표본을 추출하였고 \(T(\overline{x})\)을 모수 \(\theta\)의 충분 통계량, 그리고 \({\overset{\hat{}}{\theta}}_{mle}\)는 MLE 추정량이라 하자. \({\overset{\hat{}}{\theta}}_{mle}\)는 충분 통계량, \(T(\overline{x})\)의 함수이다.

충분 통계량의 완비성을 증명하는 것은 쉽지 않다. 단 지수족 모집단으로부터 확률표본의 통계량 \(T = \sum K(X_{i})\)는 모수 \(\theta\)의 완비 충분 통계량이다.

【정리】 지수족 확률밀도함수를 갖는 경우 \(c(\theta)\)의 최소 충분 통계량은 \(\sum K(x)\)이다.

지수족 확률밀도함수를 다음과 같이 쓸 수 있다.

\(f(x;\theta) = h(x)g(\theta)\exp{\left( c(\theta)K(x) \right) \Longleftrightarrow}exp(c(\theta)K(x) + h(x) + g(\theta))\)

\(h(x),K(x)\) : 확률변수 \(x\)의 함수, \(g(\theta),c(\theta)\) : 모수 \(\theta\)의 함수

【예제】 \(f(x;\theta) = \frac{1}{\theta},0 < x < \theta\)에서 표본크기 \(n\)인 확률표본을 추출하였다. MVUE 구하라.

\({T = X}_{(n)} \sim f(t;\theta) = \frac{nt^{n - 1}}{\theta^{n}},0 < t < \theta\)는 충분 통계량이다.

\[E_{\theta}\left( g(T) \right) = \int_{0}^{\theta}{g(t)\frac{nt^{n - 1}}{\theta^{n}}dt} = (\theta > 0,n \geq 1)\int_{0}^{\theta}{g(t)t^{n - 1}dt} = 0\] \(0 = g(\theta)\theta^{n - 1}\)을 만족하려면 \(g(\theta) = 0\)이어야 하므로 \({T = X}_{(n)}\) 완비 통계량이다.

\(E(T) = \int_{0}^{\theta}{t\frac{nt^{n - 1}}{\theta^{n}}dt = \frac{n}{n + 1}\theta}\) 이므로 \(\frac{n + 1}{n}X_{(n)}\)은 MVUE

【예제】 \(f(x;\theta) = B(\theta = p)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. MVUE 구하라.

\(f(x;\theta = p) = p^{x}(1 - p)^{1 - x} = 1(1 - p)exp(ln(\frac{p}{1 - p})x)\) 이므로 지수족이고 \(K\left( x_{i} \right) = x_{i}\). 그러므로 \(\sum x_{i}\) 완비 충분 통계량이고 \(\sum x_{i} \sim B(n,p)\) 이다. \(E\left( \sum x_{i} \right) = np\) 이므로 \(\overline{X} = \frac{\sum x_{i}}{n}\)는 MVUE이다.

【예제】 \(f(x;\theta = \lambda) = e^{- \lambda}\frac{\lambda^{x}}{x!}\)에서 표본크기 \(n\)인 확률표본을 추출하였다. MVUE 구하라.

\(f(x;\lambda) = {\frac{1}{x!}e}^{- \lambda}(ln(\lambda)x)\) 이므로 지수족이고 \(K\left( x_{i} \right) = x_{i}\). 그러므로 \(\sum x_{i}\) 완비 충분 통계량이고 \(\sum x_{i} \sim P(n\lambda)\) 이다.

\(E\left( \sum x_{i} \right) = n\lambda\) 이므로 \(\overline{X} = \frac{\sum x_{i}}{n}\)는 MVUE이다.

【예제】 \(f(x;\theta) = \left( \frac{2x}{\theta} \right)e^{- x^{2}/\theta} \sim Weibull(\gamma = 2,\theta)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. MVUE 구하라.

\(f(x;\theta) = 2x\left( \frac{1}{\theta} \right)exp( - x^{2}/\theta)\) 이므로 지수족이고 \(K\left( x_{i} \right) = x_{i}^{2}\). 그러므로 \(\sum x_{i}^{2}\) 완비 충분 통계량이다. 변수 변환 방법 \(W = X^{2},X = \sqrt{W},J = \frac{1}{2\sqrt{w}}\) 이므로 \(W \sim exponential(\theta)\)이다. \(E\left( \sum x_{i}^{2} \right) = n\theta\) 이므로 \(\frac{\sum x_{i}^{2}}{n}\) 은 MVUE이다.

【예제】 \(f(x;\theta = \mu) = N\left( \mu,\sigma^{2} \right),where\sigma^{2}isknown\)에서 표본크기 \(n\)인 확률표본을 추출하였다. 모수 \(\theta = \mu\)MVUE 구하라.

\(f(x;\theta) = \frac{1}{\sqrt{2\pi}\sigma}e^{( - \mu/2\sigma^{2})}exp(\frac{\mu}{\sigma^{2}}x - \frac{x^{2}}{2\sigma^{2}})\) 이므로 지수족이고 \(K\left( x_{i} \right) = x_{i}\). \(E\left( \sum x_{i} \right) = n\mu\) 이므로 \(\overline{X} = \frac{\sum x_{i}}{n}\)는 MVUE이다.

【정리】 추정량 \(\overset{\hat{}}{\theta}\)은 모수 \(\theta\)에 대한 MVUE이고 \(g(.)\)은 일대일 함수이면 \(g(\theta)\)의 MVUE는 \(g(\overset{\hat{}}{\theta})\) 중 불편성을 갖는 추정량이다.

【예제】 \(f(x;\theta) = B(\theta = p)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. \(\frac{p(1 - p)}{n}\)에 대한 MVUE 구하라.

모수 \(\theta = p\)에 대한 MVUE는 \(\overline{X} = \frac{\sum x_{i}}{n}\) 임을 보였다. 그러므로 \(\frac{p(1 - \theta p)}{n}\)에 대한 MVUE을 구하기 위하여 분포를 알고 있는 \(Y = \sum x_{i} \sim B(n,p)\) 함수를 이용하는 것이 적절하다. \(Y\)는 완비 충분 통계량이므로 \(Y(1 - Y)\)도 완비 충분 통계량이다.

\(E\left( Y(1 - Y) \right) = E(Y) - E\left( Y^{2} \right) = E(Y) - \left( V(X) + E(Y)^{2} \right) = np - np(1 - p) - n^{2}p^{2}\)

\(= (n - 1)p(1 - p)\) 이므로 \(\frac{\theta(1 - \theta)}{n}\) 의 MVUE는 \(\frac{Y(1 - Y)}{n(n - 1)}\)

【예제】 \(f(x;\theta) = \left( \frac{1}{\theta} \right)e^{- x/\theta} \sim exponential(\theta)\)에서 표본크기 \(n\)인 확률표본을 추출하였다. \(V(X) = \theta^{2}\) MVUE 구하라.

지수분포는 지수족이고 \(K\left( x_{i} \right) = x_{i}\)이므로\(\sum x_{i}\) 완비 충분 통계량이므로 \(\overline{X}\)는 모수 \(\theta\)의 MVUE이다. 그러므로 \(V(X) = \theta^{2}\)의 MVUE을 \({\overline{X}}^{2}\)의 함수 중 불편 추정량을 찾으면 된다.\(E\left( {\overline{X}}^{2} \right) = V\left( \overline{X} \right) + E\left( \overline{X} \right)^{2} = \frac{\theta^{2}}{n} + \theta^{2} = \frac{n + 1}{n}\theta^{2}\) 이므로 \(\frac{n\overline{X}}{n + 1}\) 은 MVUE이다.